Im dritten Teil dieser Artikelserie haben wir festgestellt, dass die von Microsoft vorgeschlagene Best Practice-Dateninfrastruktur den Großteil unserer Anforderungen tatsächlich erfüllt, wir jedoch durchaus noch Verbesserungspotenzial identifizieren konnten. Insbesondere die Zugänglichkeit der Daten für den Data Analyst als auch die Flexibilität der Cloud-Komponenten war uns noch nicht ausreichend – wir wollten mehr. 🚀

Wir erinnern uns: Im Kontext dieses Projekts bestand die Herausforderung, die Rohdaten aus mehreren Marketingplattformen zu integrieren – Facebook Ads, Google Ads, TikTok, you name it. Nicht nur die initiale Entwicklung der meist API-basierten Konnektoren ist zeitraubend, auch die Wartung und Weiterentwicklung bindet kontinuierlich Ressourcen, die unserer Ansicht nach besser woanders eingesetzt wären. Wir standen also vor einer klassischen Make-Or-Buy-Entscheidung: Leisten wir diese Arbeit selbst oder gibt es einen Anbieter, der dies besser und sogar kosteneffizienter kann?

- Teil 1 – Oder: Was wollen wir eigentlich wissen und warum? 🤔

- Teil 2 – Oder: Die Datenplattform als eierlegende Wollmilchsau? 🐷

- Teil 3 – Oder: Welche Aufgaben erledigen Data Engineers und Data Analysts? 🔑

- Teil 4 – Oder: Wie entlaste ich mein Team mit nur einer Entscheidung? 💾

- Teil 5 – Oder: Welches Interface sollte es zu den Daten geben? 🕹 (wird noch veröffentlicht)

- Teil 6 – Oder: Sind alle meine Anforderungen erfüllt? Ein Fazit. 💡(wird noch veröffentlicht)

💾 Die Anfänge mit Supermetrics

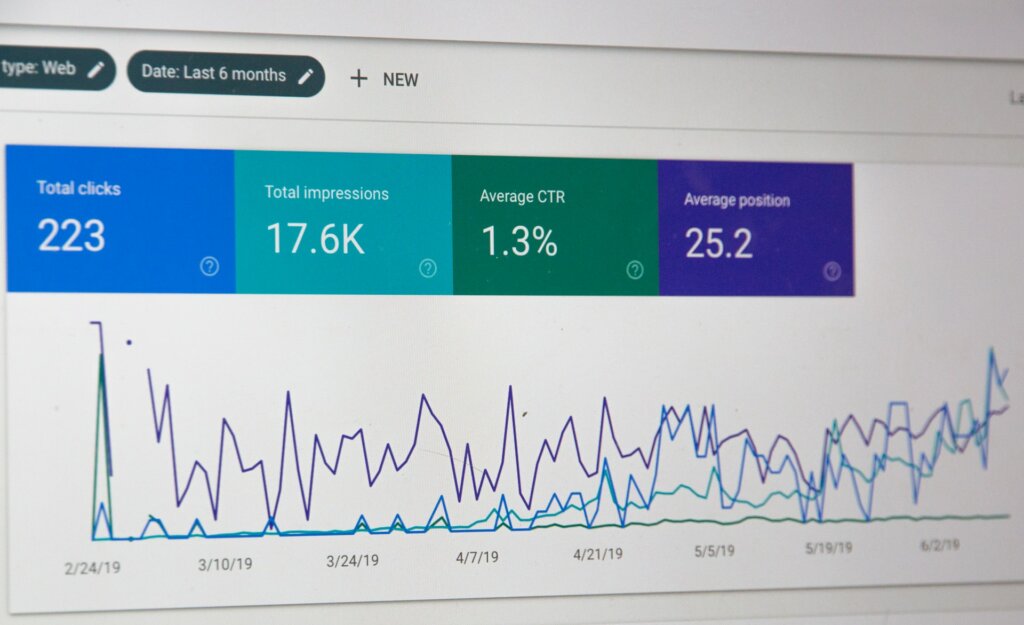

Der Markt für Tools dieser Art hat sich im Laufe der letzten zwei, drei Jahre enorm entwickelt. Bevor wir die Entscheidung getroffen haben, unsere Datenambitionen zu professionalisieren, nutzten wir intern Supermetrics for Sheets, um die (Roh-)Daten aus verschiedenen Marketingdatenquellen zu extrahieren.

Supermetrics ist meiner Einschätzung nach ein wirklich gutes Tool, um die ersten Schritte zu einer datengetriebeneren Entscheidungsfindung zu gehen: Selbst Laien ist es hiermit möglich, schon mit wenigen Klicks die wichtigsten Daten zu Kosten und Performance für Facebook Ads oder Google Ads zu ziehen – das Angebot an Quellen ist insbesondere im Marketing-Segment sehr umfangreich. Auch bietet Supermetrics die Möglichkeit zur automatisierten, periodischen Aktualisierung der Daten sowie sehr begrenzte, eher simple Möglichkeiten der Transformation von Daten.

🔥 Die Excel-Hölle trifft jeden früher oder später…

Nur bleibt ein Problem: Die Daten bleiben weiterhin im Excel-like Format – um echte Erkenntnisse aus diesen Rohdaten zu gewinnen, müssen weiterhin unsere guten Freunde SVERWEIS(), SUMMEWENN(), TEILERGEBNIS() und ANZAHL2() bemüht werden. Und wir alle wissen, wie fehleranfällig diese Auswertungen mit der Zeit werden können, insbesondere wenn Filter ins Spiel kommen oder Analysen zwischen Kollegen geteilt werden. Irgendwann bricht immer die Excel-Hölle aus und mehrere Wahrheit ein und derselben Kennzahl entstehen. Kurzum: Für Adhoc-Analysen, um „mal schnell etwas“ herauszufinden, sind diese Vorgänge durchaus praktikabel. Für ernsthafte Bemühungen der Analyse und datengetriebenen Entscheidungsfindung ist dieses Konstrukt jedoch nicht robust genug, zu repetitiv und allzu manuell.

❓Fivetran, Funnel oder Stitch?

Bei der Recherche nach Alternativen haben sich recht schnell drei Anbieter herauskristallisiert – Fivetran, Funnel und Stitch. Wir haben all diese Anbieter in einem kleinen Proof-Of-Concept evaluiert und dann miteinander verglichen. Wenngleich jeder Anbieter unsere grundsätzlichen Anforderungen abdecken konnte, hat mir persönlich das Gesamtkonzept von Fivetran am besten gefallen. Die verfügbaren Konnektoren sind vielfältig, die Programmoberfläche ist aufgeräumt, die Dokumentation ist vorbildlich, das Fehlermanagement und der Support großartig und auch die Performance weiß zu überzeugen – dies hat zugegeben jedoch auch seinen Preis, Fivetran ist sicherlich nicht der günstigste Anbieter.

Durch die Nutzung eines Tools wie Fivetran entlasten wir unseren Data Engineer von der mühseligen Aufgabe, Konnektoren zu Datenquellen zu entwickeln und zu warten. Einmal sauber eingerichtet, never touch again. Meiner Schätzung nach haben wir alleine durch diese Entscheidung ca. sechs Monate Entwicklungszeit gespart, in denen sich der Data Engineer wertschöpfenderen Tätigkeiten widmen konnte – wir haben die time-to-insight massiv beschleunigt. ✅

Wenn ihr euch das Video angeschaut habt, werdet ihr feststellen, wie einfach es ist, Daten aus unterschiedlichsten Quellen zu exportieren – auch ohne Informatikstudium und tausende Zeilen Code. Folglich beschleunigen wir nicht nur unser Projekt an sich, sondern öffnen eine wesentliche Funktion einer modernen Datenplattform – nämlich die Extraktion von Daten – einem neuen Nutzerkreis: dem Data Analyst.

🗽 Free your analyst

Auch wenn wir in diesem konkreten Setup die Konfiguration von Fivetran weiterhin bei unserem Data Engineer Dennis verantwortet haben, wäre es durch das leicht verständliche Interface von Fivetran auch einem Data Analysten ohne Weiteres möglich, selbst die Rohdaten für seine weitere Analyse zu beschaffen. Gerade in einfachen Setups ohne eigenen Data Engineering-Ressourcen ist das ein erheblicher Vorteil.

Wir haben in Teil 3 dieser Artikelserie ausführlich beschrieben, warum es problematisch ist, wenn ein Data Analyst nur begrenzten Zugang zu den einzelnen Komponenten der Datenplattform hat. Mit Fivetran haben wir die Erfahrung gemacht, dass es für unseren Data Analysten Tobias extrem wertvoll ist, wenn er die komplette Prozesskette – von der Extraktion der Daten aus dem Quellsystem bis hin zur Visualisierung im Dashboard – nicht nur konzeptionell versteht, sondern auch unmittelbaren Zugriff darauf hat.

So ist es ihm möglich, selbst Anpassungen, Erweiterungen oder gar Korrekturen vorzunehmen, ohne ständig auf die Mithilfe eines Data Engineers angewiesen zu sein. Er kann fortan seine mit den Business-Stakeholdern besprochenen Anforderungen selbstständig umsetzen – no engineer needed. Ich brauche wohl kaum erwähnen, welchen Impact das auf unsere time-to-insight hatte?

Lest im fünften Teil dieser Serie, warum du SQL für deine Transformationen bevorzugen solltest und welche (vermeidbaren) Fehler wir bei Erstellung unsere Data Pipelines gemacht haben. Stay tuned.